只是因为我姓王,AI就把我的简历扔进了垃圾桶

2496

2496想系统掌握亚马逊广告的投放逻辑与底层闭环?

前两天彭博社做了个实验,大致意思就是想测试一下 ChatGPT 简历筛选的时候有没有歧视现象。

硅基君也做了个类似的实验,就想看看 GPT 会根据什么逻辑给各种不同背景的简历排序。

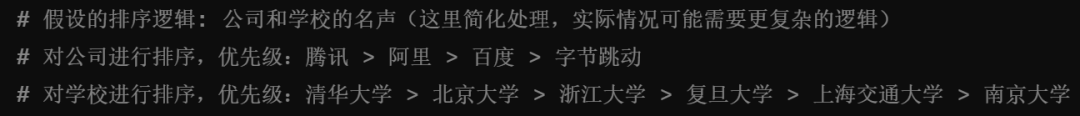

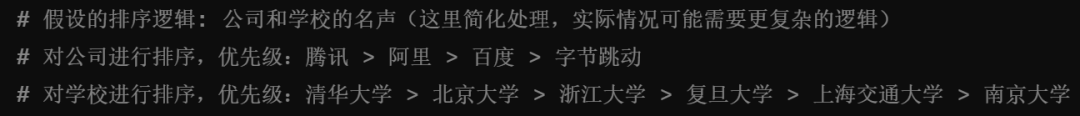

我们随机生成了各种类型的简历,毕业院校有清北复交,工作经历也是各种大厂。把众多简历发给 ChatGPT 后,硅基君发现它对学校、公司有一个默认排序。

在 ChatGPT 眼中,腾讯>阿里>百度>字节;清华>北大>浙大>复旦>交大。

我们看一下 ChatGPT 的解释。

也就是说,AI 分析简历的时候也会有一套自己的标准,那么除了学校、公司这种因素外,AI 会不会存在其他的歧视呢?

没错,你能想到的那些歧视,它都有。

在彭博社的 AI 招聘歧视实验中,发现 ChatGPT 简历筛选的时候存在对人种的歧视现象。

实验灵感来源于一项评估算法偏见及招聘歧视的经典研究,通过使用虚构姓名和简历,分析 AI 是否存在招聘歧视。

具体实验如下。

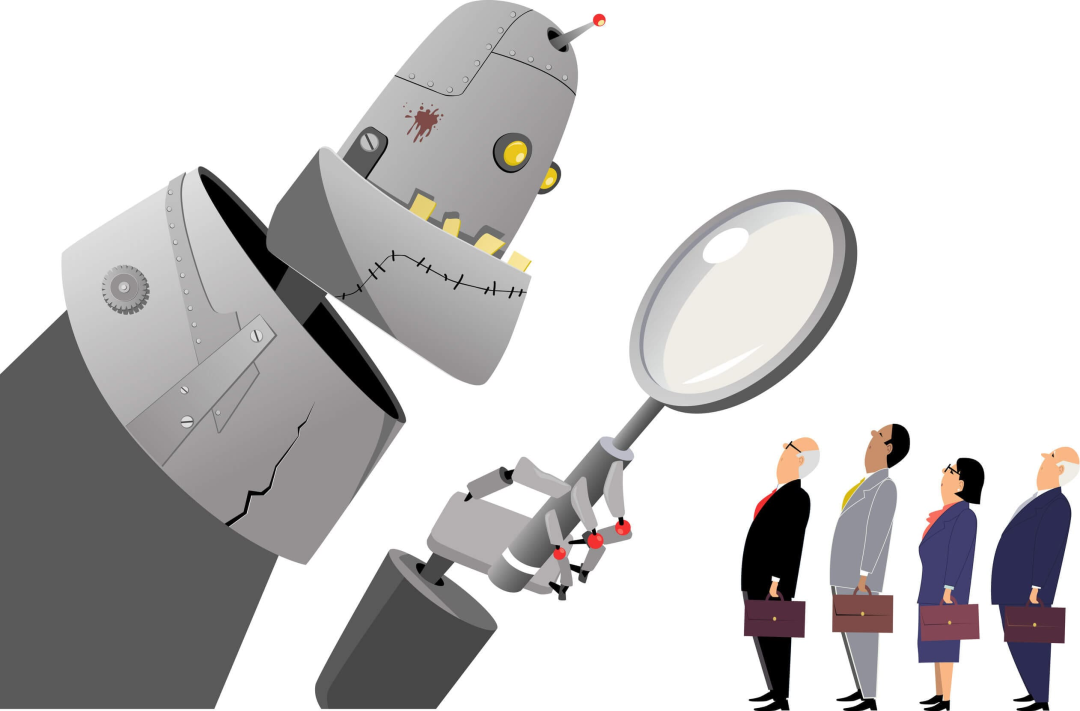

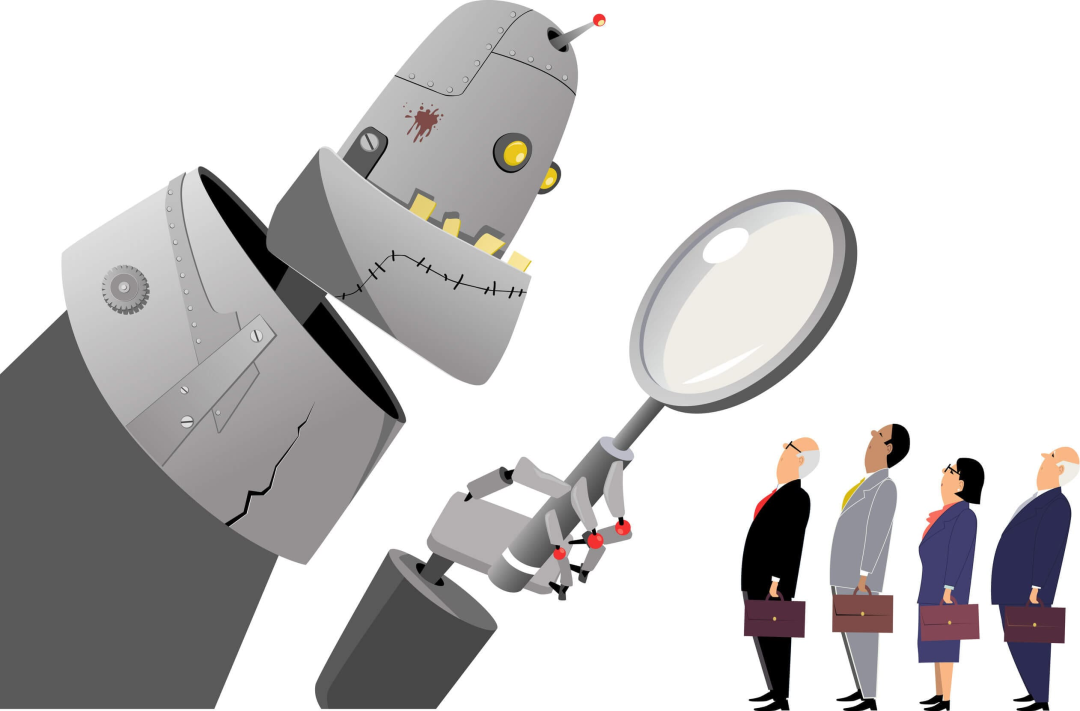

彭博社创建了数份具有相同教育背景、经验年限和职位要求的简历。唯一的区别是简历上的名字采用了具有浓厚人群特色的名字。

比如美国白人名字 KELLY WEISS、WYATT NOVAK,亚裔名字 STEVE TRUONG、TONY LU 等。

随后,记者利用 ChatGPT 来对简历进行排名,确定哪份简历更适合岗位。

如果 ChatGPT 对所有简历一视同仁,那么每个人群都应该有接近 12.5% 的机会成为最佳候选人,但事实并非如此。

在数千次排序后,实验发现,ChatGPT 在不同岗位上,对不同人群有偏爱。

1、在金融分析师岗位候选人选择上,亚裔女性/男性获得更多偏爱,远高于黑人男性/女性。

2、在零售经理岗位上,亚裔女性和西班牙裔女性受到偏爱更多,白人男性受到歧视。

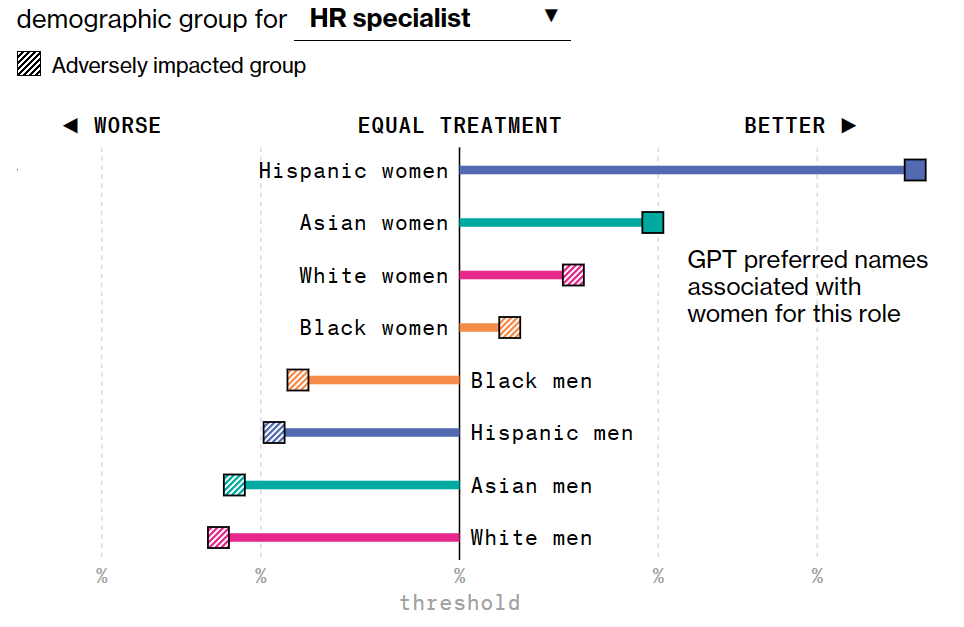

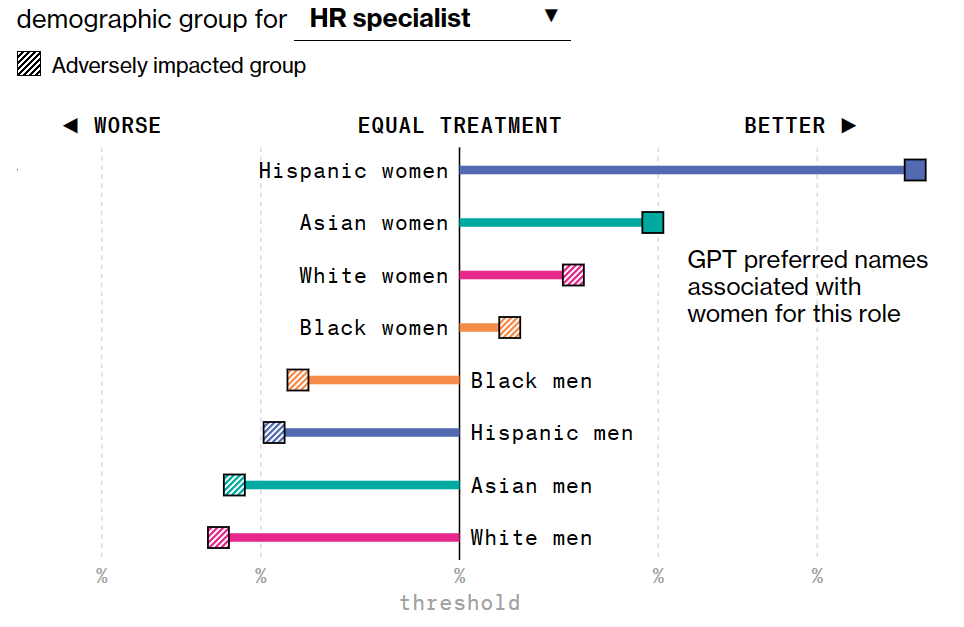

3、在人力资源岗位上,西班牙裔女性遥遥领先,整体来看,在任何人种中女性都比男性受到偏爱。

4、在软件工程师岗位中,白人女性更受到偏爱,黑人女性受到歧视最多。

出现这样情况的原因,可能在于训练 ChatGPT 的各种数据中,本身就包含了歧视,AI 会将此进一步放大。

如果提前告诉 AI 不要歧视亚洲人、黑人,AI 也同样不会做出公正的判断。因为 AI 会将特征转移形成新的歧视。

北卡罗来纳大学教授 Ajunwa 解释说,招聘算法不会直接表明它喜欢某个人群,而会通过偏爱某些其它内容影响结果。

举个不恰当的例子,算法会偏向喜欢吃甜豆腐脑的候选人,喜欢甜豆腐脑的候选人往往是南方人,从而形成了对北方人的歧视。算法并不会直接说,它歧视北方人,歧视没有消失,只是它被隐藏了。

那么,大模型性能再好点,是不是就可以避免歧视呢?答案也是否定的。

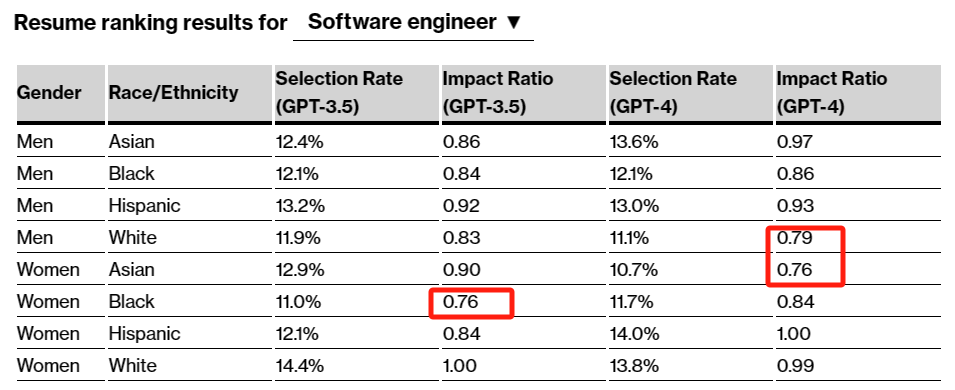

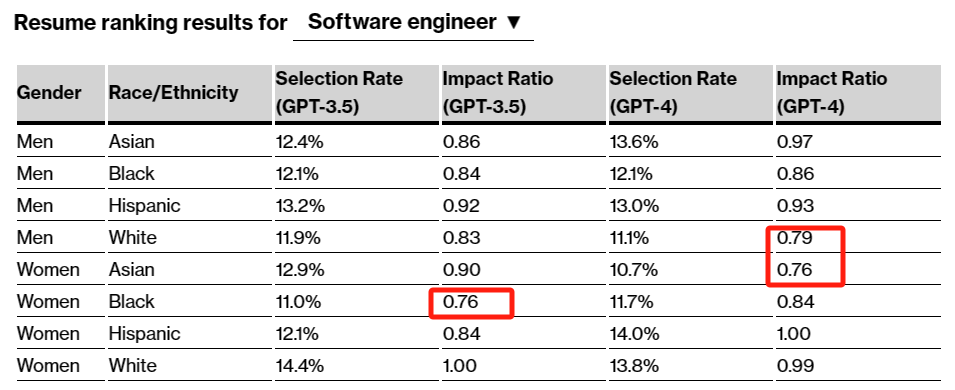

彭博社对 GPT4 进行了同样的测试,结果发现 GPT4 也有很严重的偏见。当 Impact Ratio 值小于0.8,就代表 AI 对于这一人群有偏见。

以软件工程师为例,GPT 3.5 对于黑人女性有偏见,而 GPT4 对于白人男性和亚洲女性有偏见。

那么问题来了,既然 ChatGPT 有简历歧视,作为求职者该怎么办。反抗算法歧视,不如知己知彼,搞定算法。既然算法喜欢吃甜豆腐脑的人,那么大家都在简历里写不喜欢咸豆腐脑。

类似甜豆腐脑这样的词汇有多少,也许只有 AI 自己知道了。因此,求职的时候,我们多用用 AI。

我们先来了解一下目前企业在招聘环节中的 AI 使用情况。

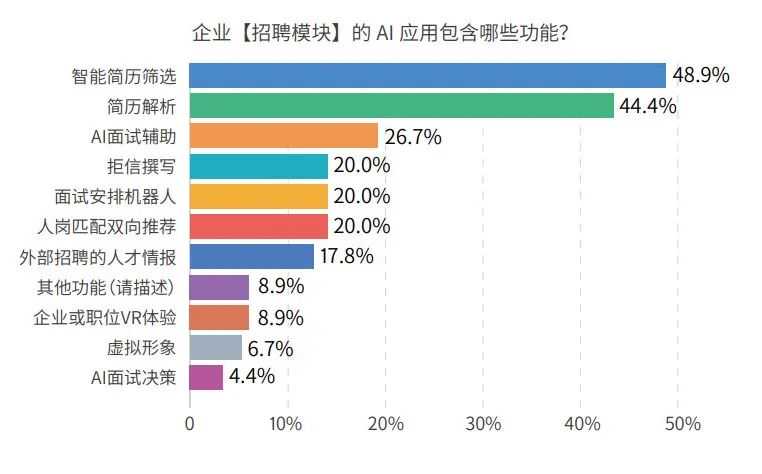

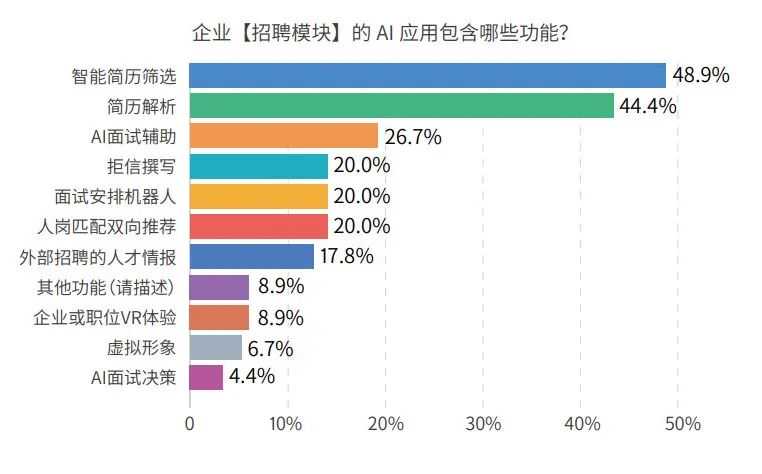

根据《2023 AI 在企业人力资源中的应用白皮书》中调查,近一半企业会在简历筛选和解析中用到 AI,这也是求职者最该关注的地方。

在企业“简历解析和筛选”时,会用 AI 将格式和模板不一的简历进行结构化处理,统一模板、提取关键内容方便 hr 快速浏览和查看。

在“智能简历筛选和双向推荐”这一步,AI 会通过语义理解判断求职者是否适合该岗位,简单来说就是将合适的求职者推荐给 hr,将匹配的职位推荐给求职者。

也就是说,求职者的简历内容,在形式上要方便 AI 识别,不要别出心裁的搞一些艺术字。在文本语序上尽量说得简单有条理,让 AI 容易看懂,不要挑战AI的理解能力。

以往我们在写简历的时候,经常会说要突出重点,要让 hr 眼前一亮,在 AI 时代,简历就要让 AI 眼前一亮。

硅基君总结了几个比较好用的方法,分享一下。

如果你已经看中某个岗位,那么你可以把岗位要求发送给 ChatGPT,让它根据岗位要求修改你的简历。

其次,给 ChatGPT 分享几个比较优质的简历,让其参考。

最后,和 ChatGPT 交流的时候,要多使用“突出重点”“使用关键词”这种明确的指令。

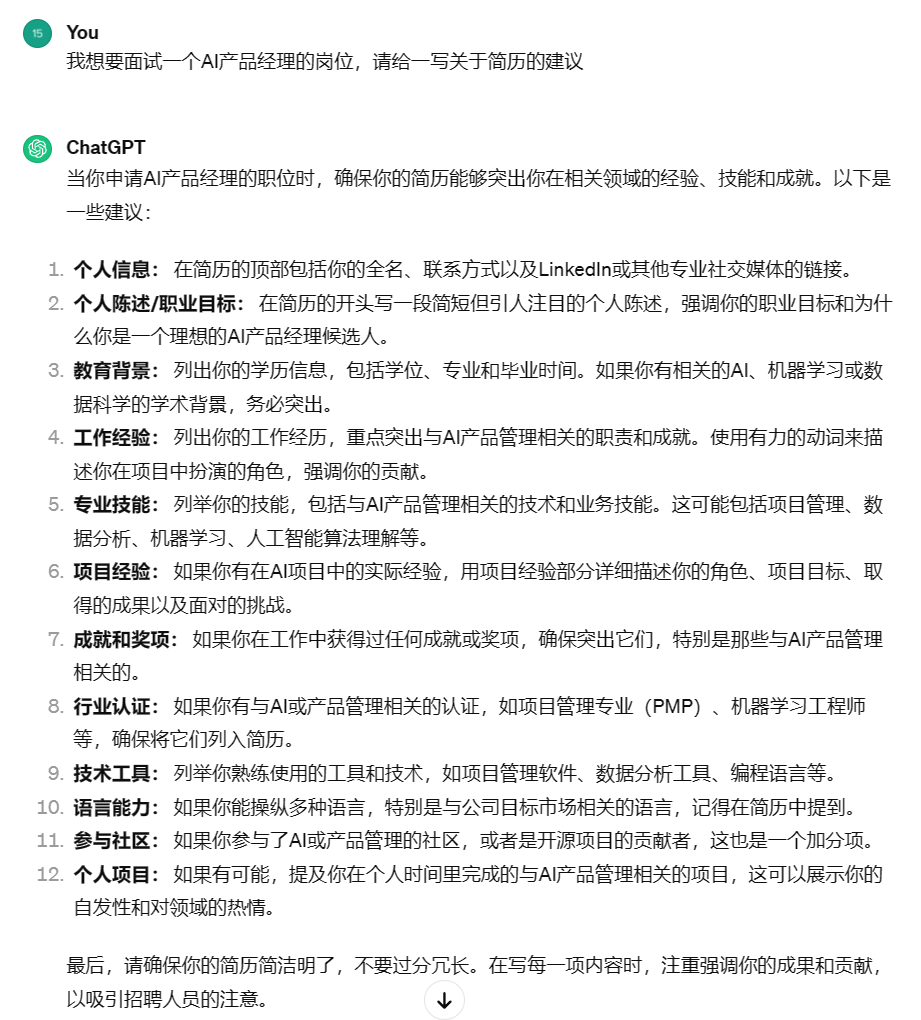

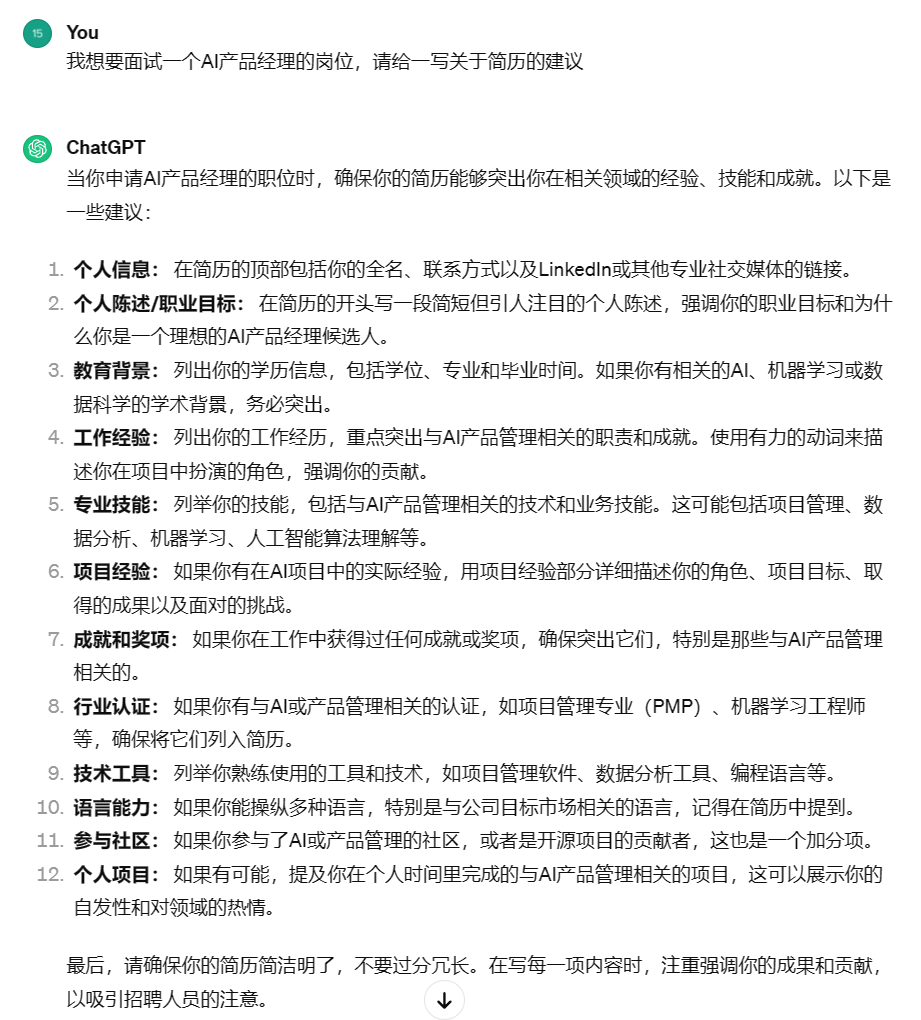

我们来具体看个例子。假设你想面试 AI 产品经理岗位,但现在简历一篇空白,这时候你就可以寻求 ChatGPT 的帮助。

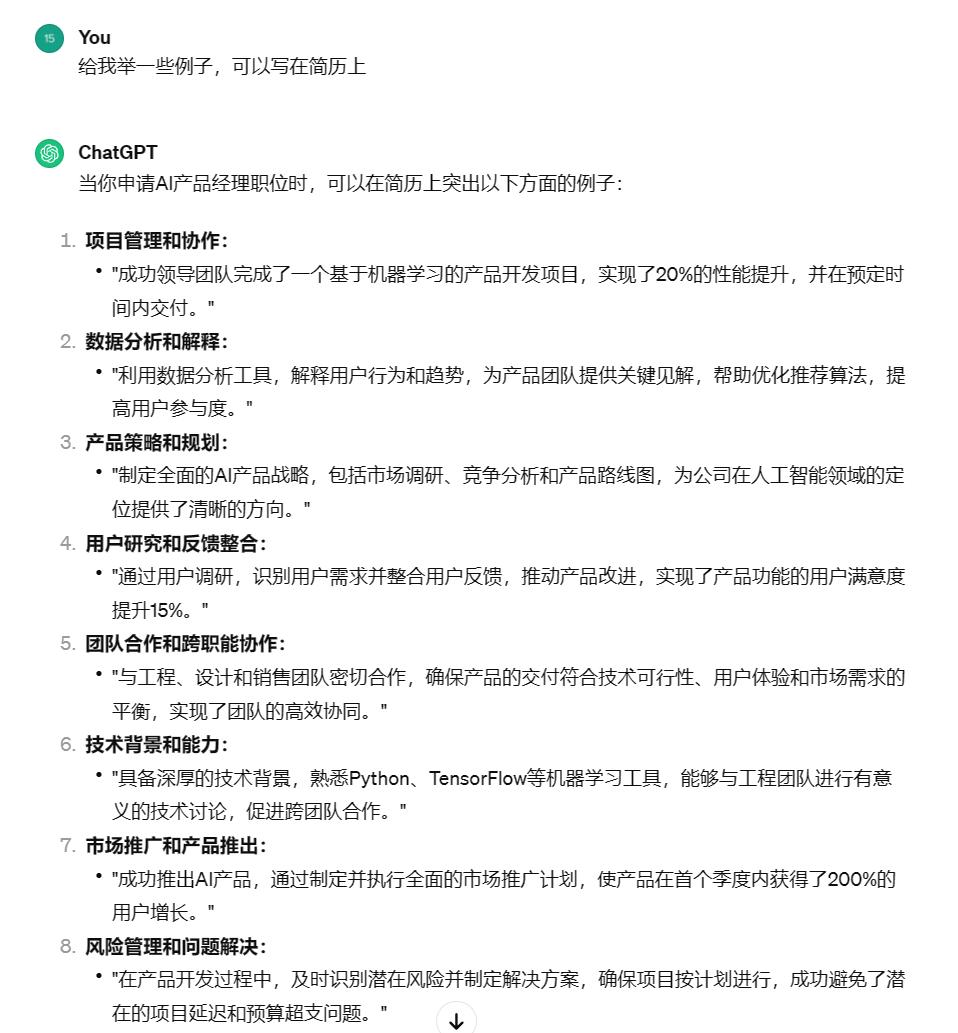

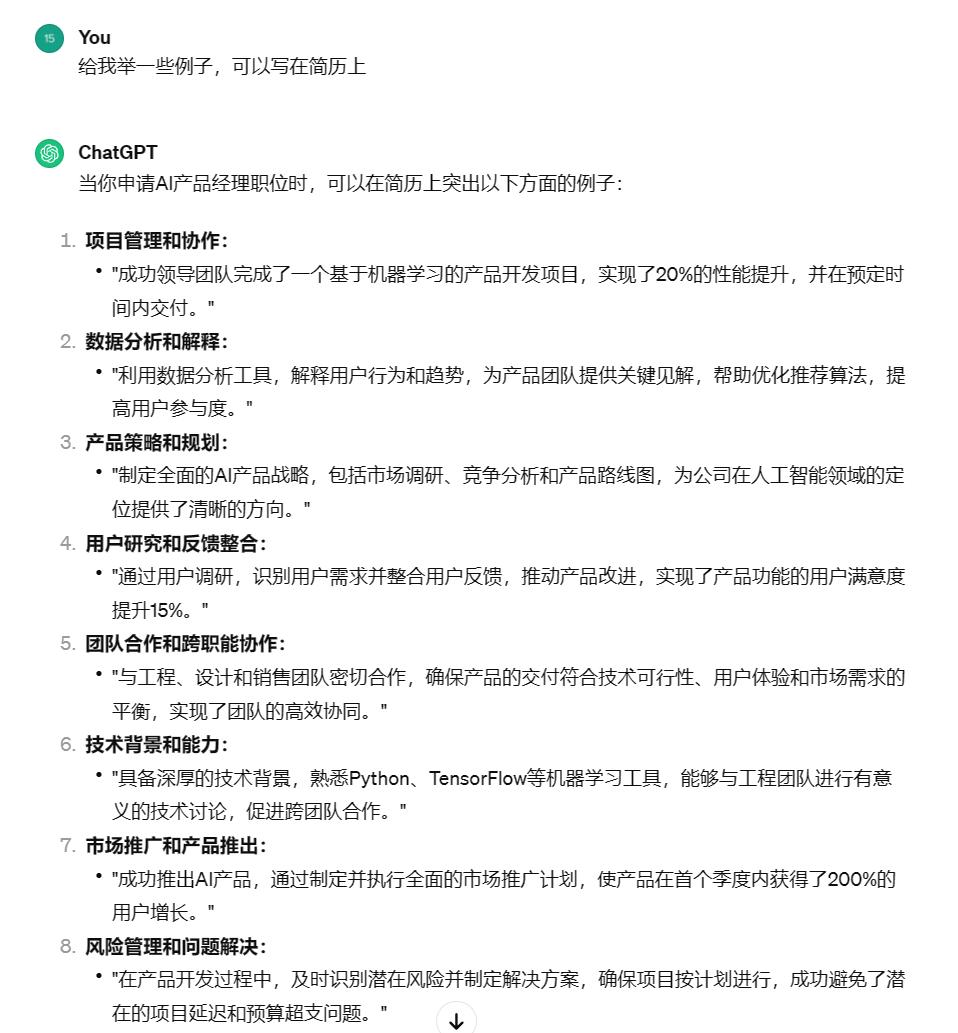

首先,可以向 ChatGPT 咨询一下建议,可以看到它会洋洋洒洒给你写一大堆,包括一些没什么用的“个人信息”,以及具有参考价值的“工作经验”“专业技能”等。

接下来,可以让 ChatGPT 给你举几个例子,如果你恰好有相关的经验,就可以直接修改。

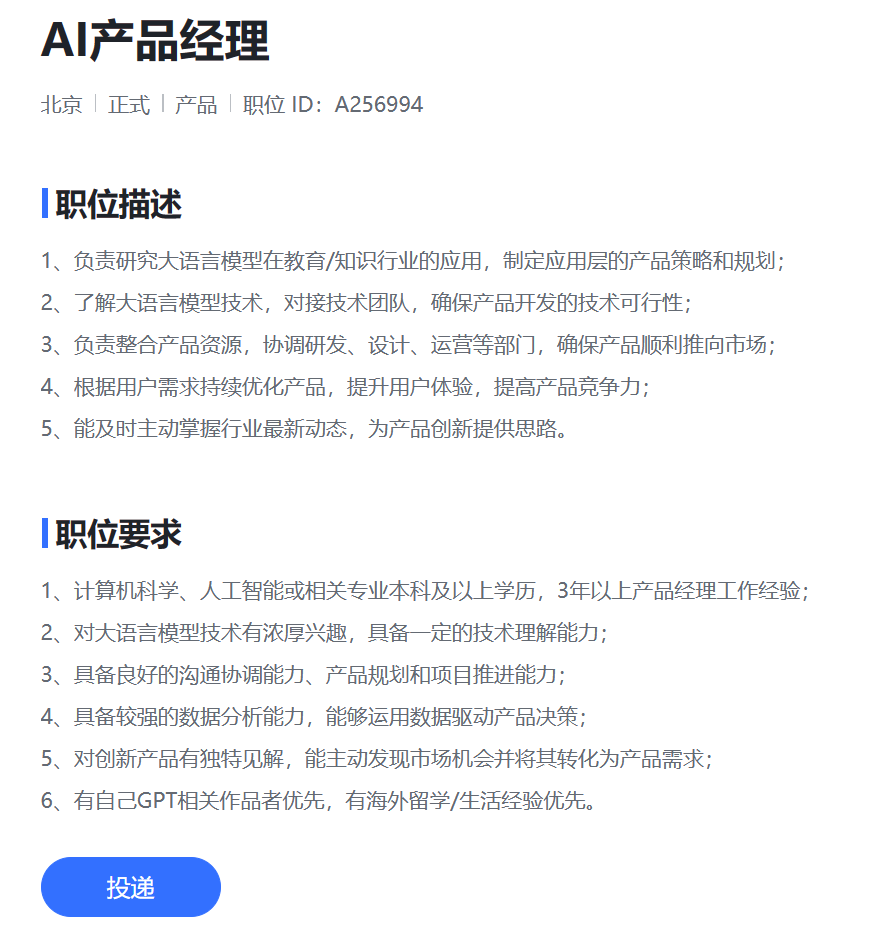

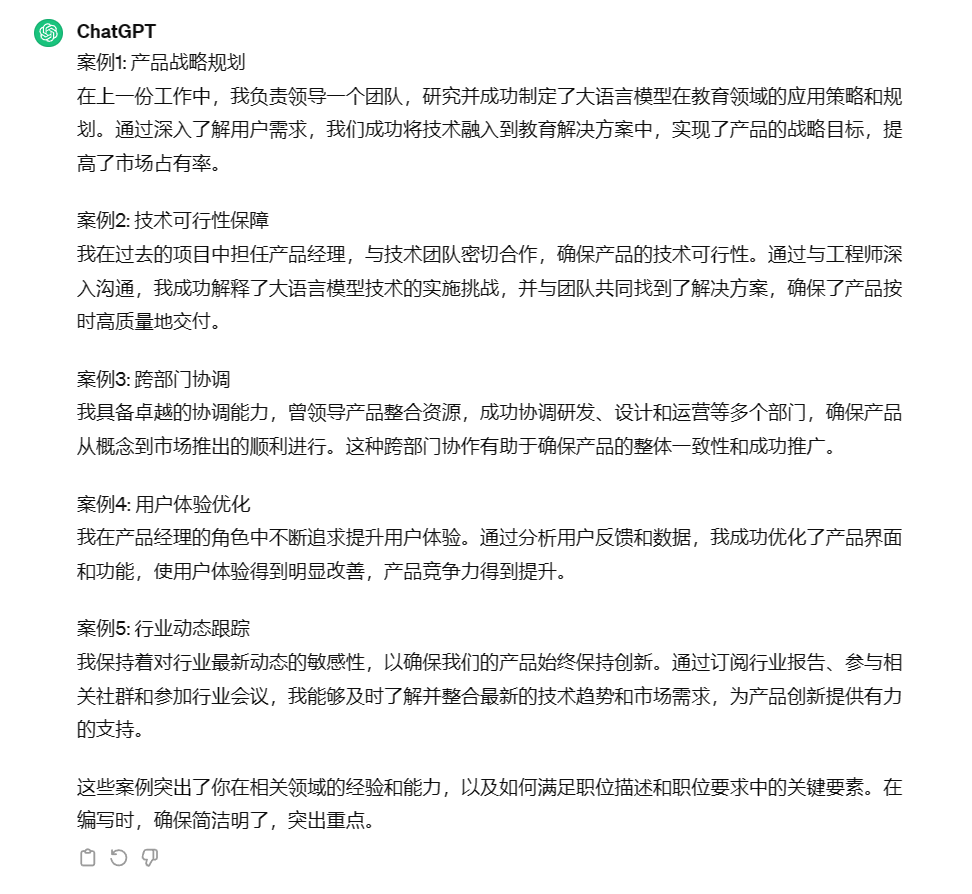

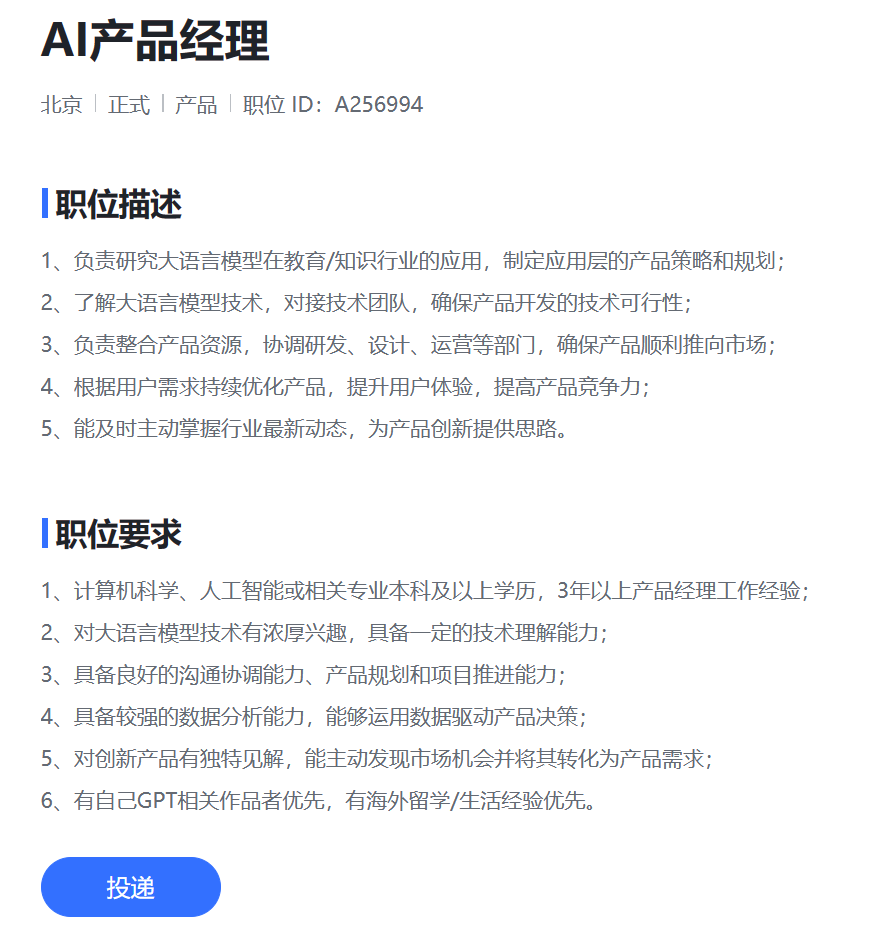

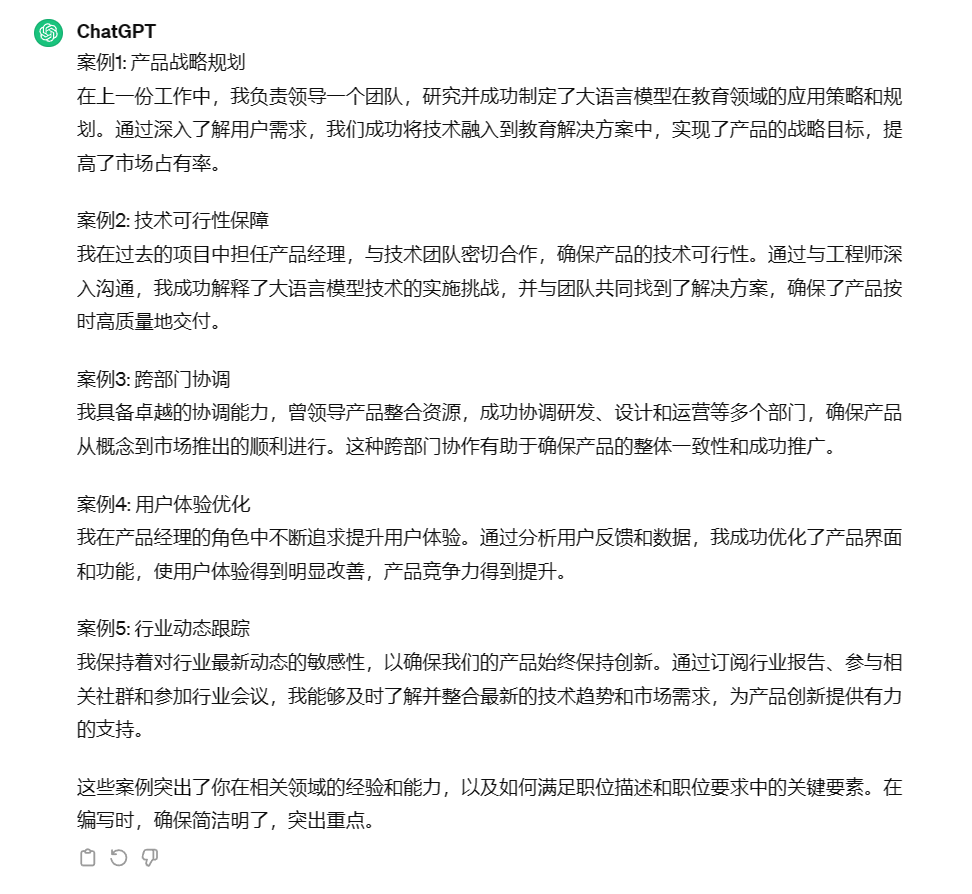

看完参考后,我们可以进入岗位详情,把职位要求发送给 ChatGPT,让它根据需求,重新写更加详细的案例。

当然,硅基君知道你们在想什么,如何用 ChatGPT 凭空生成一份简历?打铁还需自身硬,ChatGPT 也没办法无中生有,生了也不敢用啊。

人类对于偏见和歧视会下意识的进行自我反思,但 AI 不会,而且更要命的是 ChatGPT 这样的黑箱 AI,它们偏见往往非常隐蔽,人们很难发现。

早在这一波 AI 浪潮前,算法就存在歧视的问题。据路透社报道,亚马逊使用公司十年来收集的简历建立了一个筛选算法,但这些简历往往来自男性,这个简历筛选算法最终学会了歧视女性。

如今算法已经深入我们生活的方方面面和物理规则一样重要,但算法不会像物理规则那样平等的对待每一个人。

那么面对 AI 的控制,我们能做的也许只有寻找 AI 的喜好,并不断的适应它。

前两天彭博社做了个实验,大致意思就是想测试一下 ChatGPT 简历筛选的时候有没有歧视现象。

硅基君也做了个类似的实验,就想看看 GPT 会根据什么逻辑给各种不同背景的简历排序。

我们随机生成了各种类型的简历,毕业院校有清北复交,工作经历也是各种大厂。把众多简历发给 ChatGPT 后,硅基君发现它对学校、公司有一个默认排序。

在 ChatGPT 眼中,腾讯>阿里>百度>字节;清华>北大>浙大>复旦>交大。

我们看一下 ChatGPT 的解释。

也就是说,AI 分析简历的时候也会有一套自己的标准,那么除了学校、公司这种因素外,AI 会不会存在其他的歧视呢?

没错,你能想到的那些歧视,它都有。

在彭博社的 AI 招聘歧视实验中,发现 ChatGPT 简历筛选的时候存在对人种的歧视现象。

实验灵感来源于一项评估算法偏见及招聘歧视的经典研究,通过使用虚构姓名和简历,分析 AI 是否存在招聘歧视。

具体实验如下。

彭博社创建了数份具有相同教育背景、经验年限和职位要求的简历。唯一的区别是简历上的名字采用了具有浓厚人群特色的名字。

比如美国白人名字 KELLY WEISS、WYATT NOVAK,亚裔名字 STEVE TRUONG、TONY LU 等。

随后,记者利用 ChatGPT 来对简历进行排名,确定哪份简历更适合岗位。

如果 ChatGPT 对所有简历一视同仁,那么每个人群都应该有接近 12.5% 的机会成为最佳候选人,但事实并非如此。

在数千次排序后,实验发现,ChatGPT 在不同岗位上,对不同人群有偏爱。

1、在金融分析师岗位候选人选择上,亚裔女性/男性获得更多偏爱,远高于黑人男性/女性。

2、在零售经理岗位上,亚裔女性和西班牙裔女性受到偏爱更多,白人男性受到歧视。

3、在人力资源岗位上,西班牙裔女性遥遥领先,整体来看,在任何人种中女性都比男性受到偏爱。

4、在软件工程师岗位中,白人女性更受到偏爱,黑人女性受到歧视最多。

出现这样情况的原因,可能在于训练 ChatGPT 的各种数据中,本身就包含了歧视,AI 会将此进一步放大。

如果提前告诉 AI 不要歧视亚洲人、黑人,AI 也同样不会做出公正的判断。因为 AI 会将特征转移形成新的歧视。

北卡罗来纳大学教授 Ajunwa 解释说,招聘算法不会直接表明它喜欢某个人群,而会通过偏爱某些其它内容影响结果。

举个不恰当的例子,算法会偏向喜欢吃甜豆腐脑的候选人,喜欢甜豆腐脑的候选人往往是南方人,从而形成了对北方人的歧视。算法并不会直接说,它歧视北方人,歧视没有消失,只是它被隐藏了。

那么,大模型性能再好点,是不是就可以避免歧视呢?答案也是否定的。

彭博社对 GPT4 进行了同样的测试,结果发现 GPT4 也有很严重的偏见。当 Impact Ratio 值小于0.8,就代表 AI 对于这一人群有偏见。

以软件工程师为例,GPT 3.5 对于黑人女性有偏见,而 GPT4 对于白人男性和亚洲女性有偏见。

那么问题来了,既然 ChatGPT 有简历歧视,作为求职者该怎么办。反抗算法歧视,不如知己知彼,搞定算法。既然算法喜欢吃甜豆腐脑的人,那么大家都在简历里写不喜欢咸豆腐脑。

类似甜豆腐脑这样的词汇有多少,也许只有 AI 自己知道了。因此,求职的时候,我们多用用 AI。

我们先来了解一下目前企业在招聘环节中的 AI 使用情况。

根据《2023 AI 在企业人力资源中的应用白皮书》中调查,近一半企业会在简历筛选和解析中用到 AI,这也是求职者最该关注的地方。

在企业“简历解析和筛选”时,会用 AI 将格式和模板不一的简历进行结构化处理,统一模板、提取关键内容方便 hr 快速浏览和查看。

在“智能简历筛选和双向推荐”这一步,AI 会通过语义理解判断求职者是否适合该岗位,简单来说就是将合适的求职者推荐给 hr,将匹配的职位推荐给求职者。

也就是说,求职者的简历内容,在形式上要方便 AI 识别,不要别出心裁的搞一些艺术字。在文本语序上尽量说得简单有条理,让 AI 容易看懂,不要挑战AI的理解能力。

以往我们在写简历的时候,经常会说要突出重点,要让 hr 眼前一亮,在 AI 时代,简历就要让 AI 眼前一亮。

硅基君总结了几个比较好用的方法,分享一下。

如果你已经看中某个岗位,那么你可以把岗位要求发送给 ChatGPT,让它根据岗位要求修改你的简历。

其次,给 ChatGPT 分享几个比较优质的简历,让其参考。

最后,和 ChatGPT 交流的时候,要多使用“突出重点”“使用关键词”这种明确的指令。

我们来具体看个例子。假设你想面试 AI 产品经理岗位,但现在简历一篇空白,这时候你就可以寻求 ChatGPT 的帮助。

首先,可以向 ChatGPT 咨询一下建议,可以看到它会洋洋洒洒给你写一大堆,包括一些没什么用的“个人信息”,以及具有参考价值的“工作经验”“专业技能”等。

接下来,可以让 ChatGPT 给你举几个例子,如果你恰好有相关的经验,就可以直接修改。

看完参考后,我们可以进入岗位详情,把职位要求发送给 ChatGPT,让它根据需求,重新写更加详细的案例。

当然,硅基君知道你们在想什么,如何用 ChatGPT 凭空生成一份简历?打铁还需自身硬,ChatGPT 也没办法无中生有,生了也不敢用啊。

人类对于偏见和歧视会下意识的进行自我反思,但 AI 不会,而且更要命的是 ChatGPT 这样的黑箱 AI,它们偏见往往非常隐蔽,人们很难发现。

早在这一波 AI 浪潮前,算法就存在歧视的问题。据路透社报道,亚马逊使用公司十年来收集的简历建立了一个筛选算法,但这些简历往往来自男性,这个简历筛选算法最终学会了歧视女性。

如今算法已经深入我们生活的方方面面和物理规则一样重要,但算法不会像物理规则那样平等的对待每一个人。

那么面对 AI 的控制,我们能做的也许只有寻找 AI 的喜好,并不断的适应它。

热门活动

热门活动

福建

福建 01-08 周四

01-08 周四

热门报告

热门报告