如何在一天时间内从60万家店铺里面分析出利基市场?

那,这篇文章就是来填坑的,起因是在曹大(一个互联网传奇人物,cnzz的创始人,百度百科的打造者,还有很多牛逼闪闪的,不是头衔,是贡献,公众号为caozsay)的小蜜圈发了一个帖子,如下:

分享一个适合做外贸的套路,起因是上一贴分享的shopify店铺列表,分享之初预估到有人会把myip.ms拿出来说事,所以当时保守说了一个数字,10万个店铺,实际上我爬虫爬取出来的店铺数是613803家(见图一),而且是在规则里面加了限制条件的,如果真完全采集,目测得超过100万家。上一贴分享以后,就有做外贸的,私下问我,这个店铺列表有什么用?我回答说,可以找到利基市场啊,找那种需求量大,完了做得人不多的产品(这事儿我昨天花了一天时间,从60多万家里面搞掂了,找到了产品并且迅速抢占了域名(见图二),埋个伏笔,这一贴点赞数超过100,可以写一篇文章分享一下,如何在一天时间内从60万家店铺里面get到想要的信息~),然后他来了一句,然后呢,还有吗?后来想了一下,确实还有一个套路,既然我有找利基市场这个需求,那这些店铺的卖家也有,那我把店铺列表有针对性的卖给他们,也是一种变现途径。这个套路,有四个环节需要解决: 一,区分出这些店铺背后真实的国籍,很多做外贸的可能都没有想过这个问题,同样是英文站点,究竟哪些是中国人在操作的,哪些是外国人在操作的?有没有办法知道,答案是有的,伏笔二。 二,找到每个域名真实的国籍以后,需要批量的把各个域名的联系邮箱搞到手,为下一步邮件营销准备物料,测试了一下,至少90%的店铺是有邮箱的,而且是可以批量采集的,方法见图三。 三,解决多语言问题,刚才也说了,这60万家店铺,可能属于20个不同语种的国家,你也许会说,用谷歌翻译啊,我只能告诉你,谷歌翻译也是需要人工把关的,这也是为什么我说,这个操作只适合做外贸的人搞,因为他们在这一方面比较擅长,很多团队里面都有懂小语种的同事。 四,邮件群发,这个不难,国外的邮件营销很成熟,对应的邮件群发平台也很多,我随口能说出来的就有mailgun, mailchimp, mandrill. 那,这就是一个思路,我自己不会去操作,因为主业不是这个,偶尔会帮朋友采集数据是因为那种事情完全是有空闲电脑就能自动化操作的,并不影响我手上的事情。有能看懂的,并且愿意操作的,可以联系我,我提供完整的shopify店铺列表,以及伏笔二的解决方案

是不是发现我脸皮又厚啦~好在曹大是个大肚的人,不和我一般见识~完了各位看官也很给力,在周末的前一夜赞过100,所以,周末我就不用休息啦~

背景就介绍到这儿。外贸里面分两类,一类是在第三方平台混迹的,一类是自建网站的,各有千秋,暂不妄评。自建网站的,多少都会一点seo, 要站内优化嘛。无论手法是黑色的,白色的,还是灰色的,有一个地方所有人都不会含糊,也不会乱来,那就是首页的meta标签,title, keywords以及description。所以,要想在一天之内分析完60万家,需要先把这60万个网站的meta标签拿到手。这一块儿涉及到一些计算机基础知识,就不一一展开了,我们假设你手上已经从shopify上拿到了60万家店铺网址,然后自己写爬虫规则获取各个店铺首页的meta标签。我是头天晚上写好的,睡前估算了一下60多万条跑完得300分钟,电脑设置了一个360分钟后自动关机,然后就去睡了。。。等等,还有一步没搞呢,睡毛线啊。

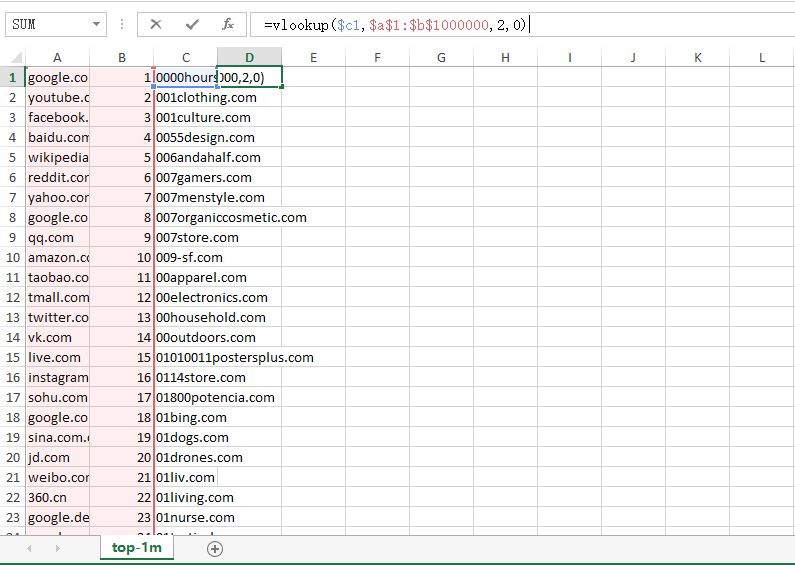

嗯呐,确实还有一步,所谓利基市场,直白点说就是,需求量大,但是操作的人不多的产品。假设某个产品的搜索量有10万加,完了就10个店铺搞,理想状态,是不是每个网站能分1万个流量?是不是比10万加流量,1万个店铺的来得多一点?有点绕了,套用一下某牛的广告吧,您的流量,超乎您的想象,这,就是利基市场。然后呢,然后。。。数钱,那是店主的事儿,和咱没关系,流量大会导致网站的排名高。国外有很多专业的网站排名工具,alexa啊,similarweb啊,虽然alexa在国内的排名不怎么准确了,国外的其实还过得去,可以直接用官方的top1m表格,全球前100万的网站列表,我在群里分享过,估计也没人当回事儿,毕竟免费的嘛。我只是用alexa举例,不代表我真正分析的时候用的这个列表,但原理是一样的~将列表打开,完了网址列和排名列对调一下,完了在C列里面粘贴60万个店铺列表,在D列里输入=vlookup($c1,$a$1:$b$1000000,2,0),然后双击至60万的底部,嗯,到这儿就可以去睡觉了(当然,程序员有更便捷的方式)。

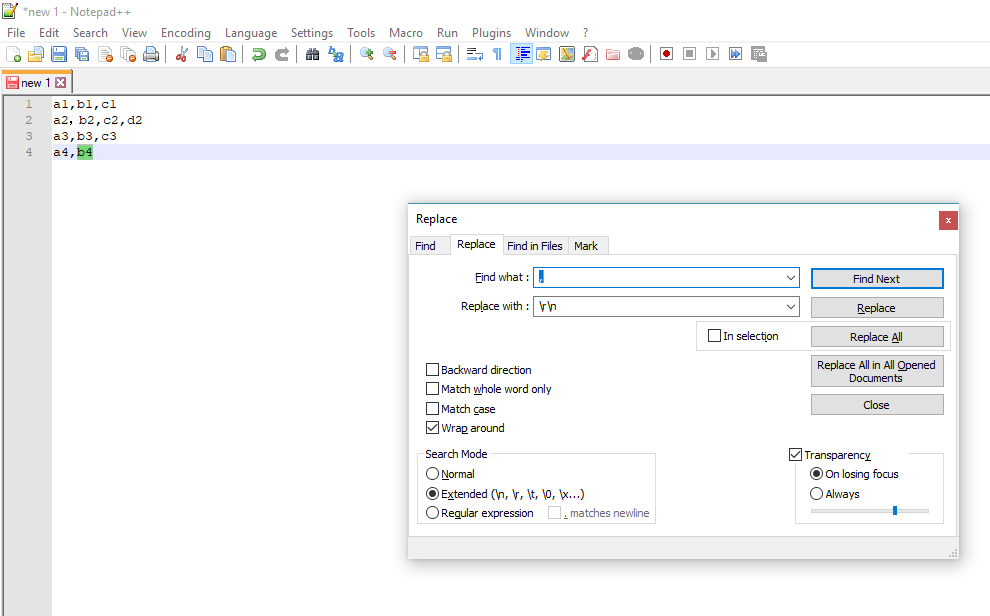

早上起来,油条没有,meta到手,排名也妥妥的。精细点,可以把title和description做个分词,但其实略懂seo的,直接看他网站的keywords就够了,我是比较懒的那种,所以就直接用的keywords, 然后在notepad++里面做了一个替换,将关键词里面的逗号和分号全部替换成换行符。

完了分批次的将所得数据转移到excel表格,为什么分批次呢,因为就算每个网站平均只有5个关键词,换行以后也有300万行,普通excel的最大行数只有100多万,故需分批次。去掉空格行,完了保留一份,完了再删除重复项,完了用countif在excel里面做词频统计,这事儿程序员搞的话,直接在数据库里面很容易搞定,奈何我大学学生物的,工作以后又保持了懒的作风,所以只能走苦逼的路线。自己设置一个阀值,词频大于某个值的关键词全部pass掉,完了用剩下的关键词回到最初的60万条meta表里,将包含这些关键词的网站筛选出来,完了把头天晚上得到的网站排名整合进来,那种没有排名的,pass掉,剩下的,其实就不多了(和60万比起来~),完了逐条看title和discription, 一般来说,keywords不会偏离另外两个标签。看的过程中,脑补一下用户的使用场景,是不是存在一个不为太多人知晓的市场,完了拿这些关键词去各个关键词平台核实(我平时用的是adwords背后的google keywords),用户搜索量是不是很大。如果是,那恭喜你,你中奖了。

很轻松,对不对?嗯,那是我没把所有的细节一一展开,只说了一个梗概,等我分析出利基市场,抢注域名的时候,其实已经快晚上12点了,中途就干了两件事儿,除了吃饭,就是等着吃饭~

本来这篇文章没打算再放出来的,据说又有人在惦记了,原文不放出来,对不起观众哈,啊哈哈哈。

说一下,当时写这篇文章的时候,故意留了一个逻辑漏洞,有100多个朋友私下就这篇文章和我讨论过,其中有一个发现了这个漏洞,很厉害的。原文没改,直接放出来的。

选品这个,我初期是用的这个方法,现在基本只做参考了。数据是否有用,在于如何用,而且,也不要把思维局限于数据本身,比如,我曾经和一行业大佬(培训行业曾经的风云人物,因为爱,放弃事业,来到了重庆) 线下沟通,在他看来,图片,视频,都是数据,而在这之前,我就只把excel里的数字当成数据,和他的视野比起来,真的是相形见拙。

再就是,现在店铺数据,筛选过后,有81万条,不加筛选的,有120多万条。没有要卖数据的打算,也没有免费分享的觉悟,所以,大家看看就好~~